Пагинация — неотъемлемая часть многих сайтов, особенно интернет-магазинов, новостных порталов и каталогов, где контент разбит на страницы для удобства навигации. Однако с точки зрения SEO такая структура может создавать серьезные проблемы: дублирование контента, распределение ссылочного веса между страницами и индексирование ненужных страниц. В этой статье мы подробно разберем, как правильно оптимизировать пагинацию для поисковых систем Google и Яндекс.

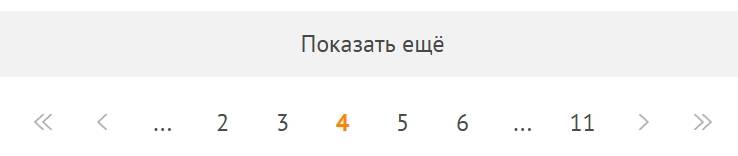

Страницы пагинации — это последовательные страницы сайта, на которых размещён разбитый на части контент (например, товары или статьи), позволяющие пользователю пошагово просматривать информацию.

Что такое пагинация и зачем она нужна?

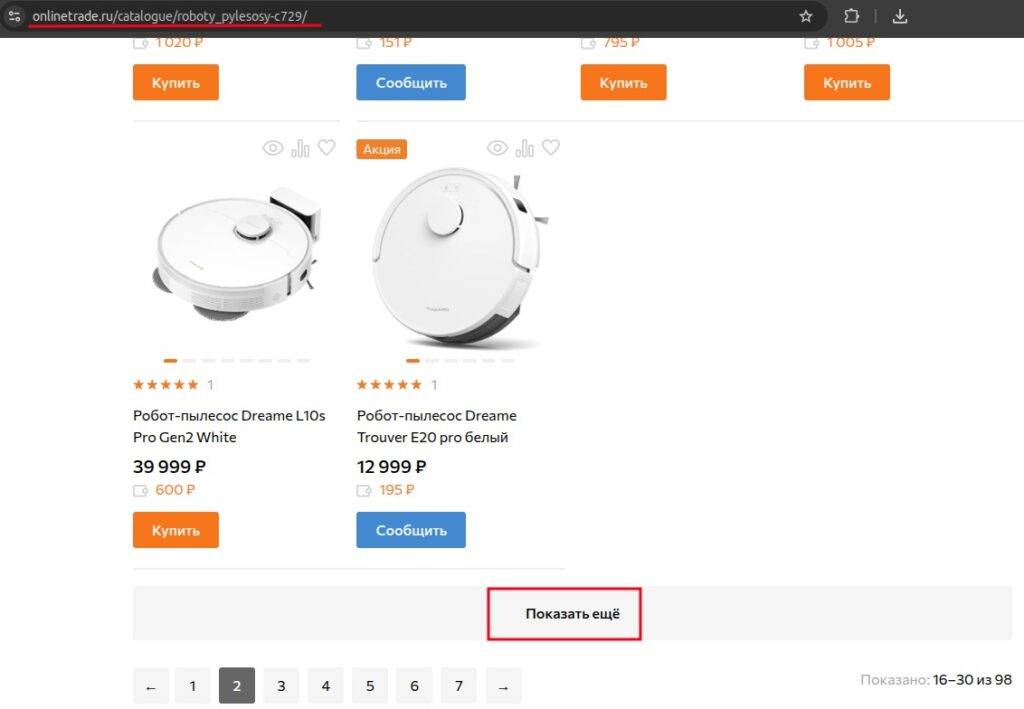

Пагинация представляет собой разделение большого объема контента на отдельные страницы с порядковой нумерацией. На сайте этот элемент выглядит как блок навигации с номерами страниц, кнопками «Далее» и «Назад».

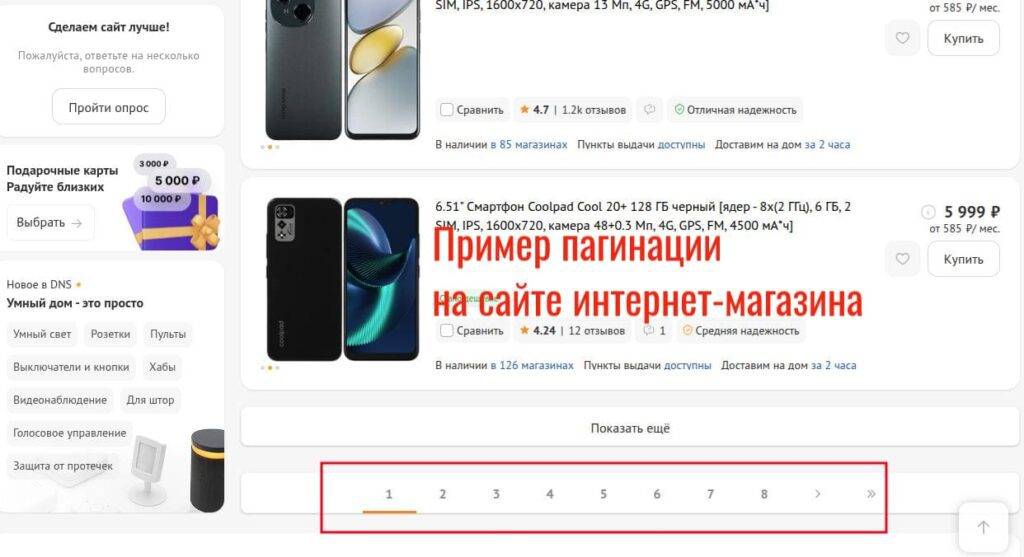

В интернет-магазинах пагинация разбивает каталог товаров на управляемые части. Например, категория с 300 товарами делится на 10 страниц по 30 позиций. Блоги используют пагинацию для архивов статей, новостные сайты — для листинга публикаций.

Основные цели внедрения пагинации:

- Ускорение загрузки страниц за счет уменьшения объема отображаемого контента;

- Улучшение пользовательского опыта через структурированную подачу информации;

- Снижение нагрузки на сервер при обработке запросов;

- Повышение удобства навигации по большим массивам данных.

Правильно настроенная пагинация помогает пользователям быстро находить нужную информацию, не просматривая слишком много элементов за раз.

Проблемы пагинации для SEO

Некорректная реализация пагинации создает препятствия для продвижения сайта. Поисковые системы сталкиваются с трудностями при определении релевантных страниц и распределении ссылочного веса. Рассмотрим основные проблемы и их влияние на SEO.

Дублирование контента

Страницы пагинации часто содержат идентичные метатеги title и description. Заголовки H1 повторяются на всех страницах раздела. Текстовые блоки и описания категорий дублируются без изменений.

Типичный пример дублирования на сайте интернет-магазина:

- Страница 1: <title>Смартфоны – купить в Москве</title>

- Страница 2: <title>Смартфоны – купить в Москве</title>

Такое дублирование затрудняет определение главной страницы для ранжирования. Google Search Console покажет эти страницы в отчете “Исключено” с пометкой “Страница является копией”. Яндекс.Вебмастер выделит их в разделе “Дубли страниц”.

Некорректное ранжирование

Поисковые системы не всегда правильно определяют приоритетную страницу. Вместо первой страницы категории в выдаче может появиться страница пагинации с номером page=4 или page=5.

Проблемы с краулинговым бюджетом

Поисковые роботы тратят ресурсы на сканирование множества страниц пагинации. Краулинговый бюджет — количество страниц, которое робот просканирует за одно посещение сайта. Для молодых сайтов это может быть 100-500 страниц, для крупных проектов — несколько тысяч.

Пример расхода краулингового бюджета:

- Категория “Телефоны”: 50 страниц пагинации

- Категория “Планшеты”: 30 страниц пагинации

Робот потратит 80 запросов только на страницы пагинации трех категорий. При этом новые товарные карточки или важные статьи блога могут остаться непроиндексированными неделями.

Нагрузка на сервер

Частые запросы поисковых ботов к страницам пагинации создают дополнительную нагрузку. Если робот сканирует сотни таких веб-страниц, это создает нагрузку на базу данных.

Дополнительные проблемы возникают при использовании динамических параметров в URL. Каждая сортировка или фильтр создает новые варианты страниц, увеличивая нагрузку в геометрической прогрессии.

конверсии вашего сайта

в Яндекс-Директ

Уже скачали 1348 раз

Как настроить пагинацию

Существует несколько методов оптимизации.

| Метод | Плюсы | Минусы |

| Rel=next/prev | Простая реализация | Google не учитывает с 2019 года |

| Rel=canonical | Универсальность | Риск потери страниц в индексе |

| Noindex, follow | Полный контроль индексации | Потеря трафика со страниц пагинации |

| AJAX | Удобство для пользователей | Сложность настройки для SEO |

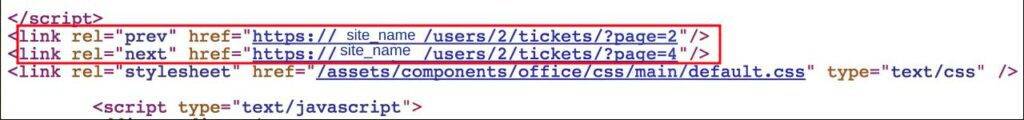

Использование атрибутов rel=”next” и rel=”prev”

Атрибуты rel=”next” и rel=”prev” указывали поисковым системам на последовательность страниц. Google официально прекратил поддержку этих атрибутов в марте 2019 года. Яндекс частично учитывает данную разметку, но не рекомендует полагаться только на нее.

Пример кода для второй страницы:

<link rel=”prev” href=”/category/page-1“>

<link rel=”next” href=”/category/page-3“>

Несмотря на отмену поддержки Google, некоторые SEO-специалисты продолжают использовать эти атрибуты для семантической разметки. Однако полагаться исключительно на этот метод не стоит.

Указание канонического URL (rel=canonical)

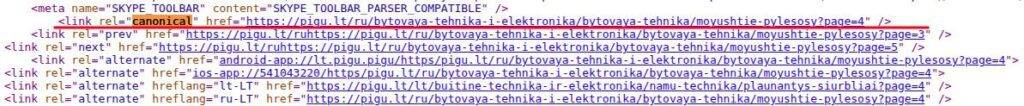

Атрибут rel=”canonical” указывает поисковым системам главную версию страницы. Существует два подхода к использованию canonical на страницах пагинации.

Первый подход — каждая страница ссылается сама на себя:

<!– На странице /category/page-2 –>

Второй подход — все страницы указывают на первую:

<!– На любой странице пагинации –>

<link rel=”canonical” href=”/category/“>

Google рекомендует первый вариант, где каждая страница пагинации является канонической для себя. Это обеспечивает корректную индексацию всего контента. Указание canonical на первую страницу может привести к игнорированию остальных страниц роботами.

Что касается Яндекса, у него есть специальная директива для robots.txt — Clean Param (Очистка параметров), который позволяет явно указать, какие GET-параметры в URL не влияют на содержание страницы (например, ?page=2, ?sort=price). В robots.txt можно настроить Clean Param, чтобы поисковик понимал:

«Этот URL с параметром page — это просто часть пагинации, а не дубль или отдельная страница».

Такой подход помогает Яндексу правильно кластеризовать страницы, избегать дублей и эффективно распределять ссылочный вес.

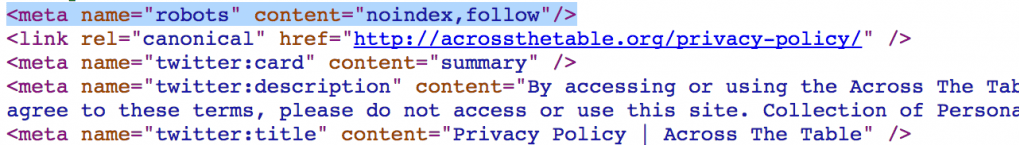

Директива noindex, follow и полное закрытие пагинации

Метатег noindex запрещает индексацию страницы, но позволяет следовать по ссылкам. Применяется для страниц пагинации начиная со второй:

<!– На страницах 2, 3, 4 и далее –>

<meta name=”robots” content=”noindex, follow“>

Первая страница остается открытой для индексации. Метод эффективен для сайтов с дублированным контентом на страницах пагинации. Яндекс рекомендует именно этот подход для большинства случаев.

Особенности работы с AJAX-пагинацией

AJAX-пагинация загружает контент динамически без перезагрузки страницы. URL может оставаться неизменным или меняться через хэш (#page=2). Для корректной индексации необходимо:

- Реализовать серверный рендеринг для поисковых ботов;

- Использовать History API для изменения URL;

- Предоставить альтернативную HTML-версию;

- Настроить правильные метатеги для каждого состояния.

Современные поисковые системы лучше обрабатывают JavaScript, но полная поддержка AJAX-пагинации требует дополнительных настроек.

Рекомендации от поисковых систем: Google vs Яндекс

Поисковые системы предлагают разные подходы к оптимизации пагинации. Понимание их особенностей поможет выбрать оптимальную стратегию.

Позиция Google

Google исторически поддерживал атрибуты rel=”next” и rel=”prev”, но отказался от них в 2019 году. Текущие рекомендации Google:

- Создание страницы “View All” со всем контентом и установка на нее canonical;

- Использование canonical для каждой страницы пагинации;

- Фокус на качестве пользовательского опыта;

- Оптимизация скорости загрузки страниц.

Google автоматически определяет структуру пагинации и выбирает релевантные страницы для показа в выдаче. Система учитывает поведенческие факторы и качество контента.

Подход Яндекса

Яндекс более консервативен в отношении пагинации и предоставляет четкие рекомендации:

- Использование noindex, follow для всех страниц кроме первой;

- Применение rel=”canonical” и Clean Param;

- Строгий контроль дублированного контента;

- Обязательная уникализация метатегов.

Яндекс жестче относится к дублям и может применять санкции за некорректную настройку. Рекомендуется следовать официальным указаниям из справки Яндекс.Вебмастера.

Вывод

Оптимизация страниц пагинации требует комплексного подхода. Универсального решения не существует — выбор метода зависит от специфики сайта.